So bringen Forscher Robotern das sehen bei

An der Uni Bayreuth entwickeln Forscher neue Technologien damit Roboter ihre Umgebung noch präziser wahrnehmen, interpretieren und darauf reagieren können.

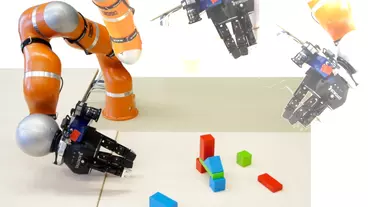

Im Projekt „SeLaVi“ werden Roboter in die Lage versetzt, auf der Basis von wenigen charakteristischen Bildern zu erkennen, was sich in ihrer Umgebung abspielt. Der Projektname steht dabei für Semantic and Local Computer Vision based on Color/Depth Cameras in Robotics. Geleitet wird das Projekt von Prof. Dr. Dominik Henrich am Lehrstuhl für Robotik und Eingebettete Systeme.

Zentrale Rolle spielen dabei Kameras, die an den Armen der Roboter befestigt sind. Die Kameras nehmen von den Objekten in ihrer Arbeitsumgebung Bilder auf, die dann in geometrische Modelle übersetzt werden. Für diese Modelle ist es charakteristisch, dass sie nur wenige, aber repräsentative Oberflächenstücke der Objekte abbilden. Sie heißen daher Boundary Representations (BReps) und beanspruchen geringere Speicher- und Rechenkapazitäten als die Punktwolken oder Dreiecksnetze, die bisher üblicherweise zur Objekterkennung verwendet werden.

Bilder abgleichen, Fehler erkennen

Die neuartigen Modelle werden mit zusätzlichen, in den Kamerabildern enthaltenen Farbinformationen zusammengeführt und in einer Datenbank gespeichert. Indem die Roboter neu hinzukommende Kamerabilder mit der Datenbank abgleichen, können sie Objekte in ihrer Umgebung fehlerfrei wiedererkennen. Dabei lassen sie sich nicht durch Bewegungen benachbarter Objekte irritieren.

Diese Fähigkeit der Roboter bildet die Grundlage für weitere Lernschritte, welche die Sinnzusammenhänge zwischen den statischen oder bewegten Objekten in ihrem Arbeitsumfeld betreffen. Roboter sollen diese „semantischen Relationen“ verstehen lernen, um dann mit ihren Armen auf zweckmäßige Weise in die jeweiligen Szenarien eingreifen zu können.

Die Anwendungsgebiete für diese Technologie sind vielfältig: Angefangen von autonomen Servicerobotern bis hin zu Kooperationen zwischen Menschen und Robotern. „Diese Entwicklungen zeigen beispielhaft, wie sich nicht nur die industrielle Arbeitswelt, sondern auch unser Lebensalltag im Zuge der Digitalisierung verändert. Mit unseren Forschungsarbeiten wollen wir nicht zuletzt dazu beitragen, dass automatisierte Serviceleistungen die Menschen auch in ihren privaten Haushalten entlasten und die tägliche Lebensqualität erhöhen“, sagt Henrich.

Objekte mittels Tiefenkameras erfassen

Das Projekt knüpft an ein thematisch ähnliches Bayreuther Forschungsvorhaben an, das ebenfalls von Henrich koordiniert wird. Hier geht es darum, Objekte mittels handgehaltener Tiefenkameras sensorisch zu erfassen und die erzeugten Bilder in CAD-Modelle zu übersetzen. Ganz automatisch – ohne, dass der Benutzer spezielles Fachwissen benötigt.

Um die anfallenden Rechenleistungen gering zu halten, wird getestet, inwieweit niedrige Auflösungen der Bilder schon ausreichen, um anhand der daraus generierten CAD-Modelle Objekte identifizieren zu können. Ziel ist es, mit einer vergleichsweise leistungsschwachen Rechen-Hardware räumliche Szenarien zu interpretieren, in denen Objekte mit unterschiedlichen Eigenschaften, Formen und Funktionen sinnvoll einander zugeordnet sind. „Die Ergebnisse dieser Forschungsarbeiten sind sehr hilfreich für unsere Weiterentwicklung von Robotern, die zuverlässige Serviceleistungen erbringen sollen, ohne vom Benutzer vertieftes Fachwissen oder hohe Rechnerkapazitäten zu verlangen. Wenn die Tiefenkameras vom Arm eines Roboters gehalten werden, können sie wie Augen fungieren, die ihm eine zuverlässige Orientierung in seiner Arbeitsumgebung ermöglichen“, erklärt Projektleiter Henrich.

db

Passend zu diesem Artikel